AWS Lambdaでもっと楽しくコーディングしてみませんか?

Lambda × Pythonの組み合わせなら、サーバー管理から解放されて、本来のプログラミングに集中できます。

しかも、普段使っているPythonの知識やライブラリをそのまま活かせるんです。

この記事では、Lambda × Pythonで実際のシステムを作る方法を、具体的なコード例を交えながら紹介していきます。

「どうやってコードを設計すべき?」「パフォーマンスを出すコツは?」など、実践的なテクニックをお伝えします。

ぜひ最後まで読んで、あなたのPythonスキルをクラウドでも活かしてみませんか?

効率的な開発環境のセットアップ

AWS LambdaとPythonによる開発のために、まずは開発環境の構築が必要です。

特に、本番環境でのトラブルを未然に防ぐために、ローカル開発環境の整備は必須となります。

開発に必要なツールの準備

以下のツールをインストールすることで、効率的な開発が可能になります。

| ツール名 | 用途 | 備考 |

|---|---|---|

| VS Code | コードエディタ | 無料で高機能な開発環境 |

| Python 3.9以上 | 実行環境 | Lambda最新ランタイムに対応 |

| AWS CLI | AWSリソース操作 | デプロイとテストに必須 |

開発効率を高める拡張機能

VS Codeでの開発効率を高めるために、以下の拡張機能をインストールしましょう。

AWS Toolkit

- Lambda関数のローカルテストが可能です。

- CloudWatchログの確認が容易です。

- デプロイ作業を効率化できます。

Python Extension

- コード補完機能により入力を効率化します。

- リアルタイムで構文エラーを検出します。

- デバッグ機能でトラブルシューティングが容易です。

必須パッケージのインストール

以下のコマンドで、開発に必要なパッケージをインストールします。

# pip install boto3 pytest python-dotenvパッケージのバージョン管理のために、requirements.txtを作成しましょう。

boto3==1.26.137

pytest==7.3.1

python-dotenv==1.0.0これらのパッケージは、以下の用途で使用します。

- boto3: AWS各種サービスの操作

- pytest: ユニットテストの実行

- python-dotenv: 環境変数の管理

実践的なコード設計パターン

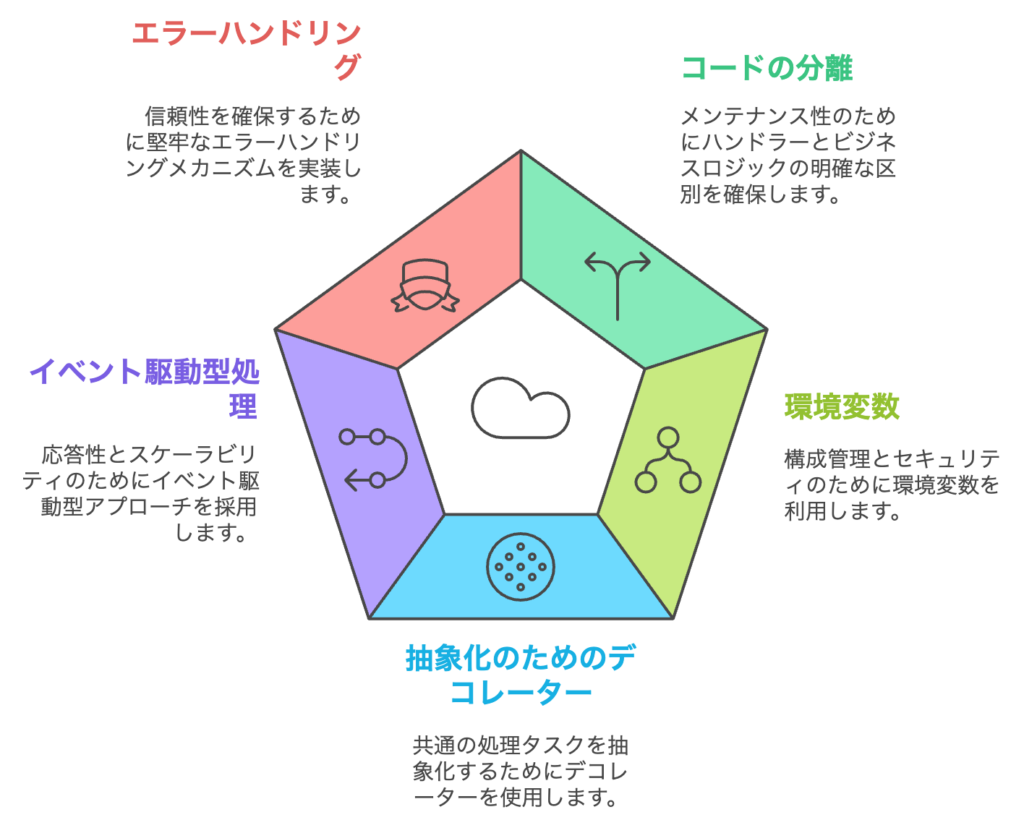

AWS LambdaをPythonで実装する場合、効率的でメンテナンス性の高いコードを書くために、以下のような設計パターンがおすすめです。

ハンドラーとビジネスロジックの分離

- ポイント: Lambdaのハンドラー関数 (

lambda_handler) は、リクエストの受け渡しや初期化に特化し、ビジネスロジックは別の関数やモジュールに分離します。 - メリット:

- コードの再利用が容易。

- テストが簡単(ハンドラーをモックし、ロジックを直接テスト可能)。

例:

# logic.py

def process_data(event):

# ビジネスロジック

return {"message": "Success"}# lambda_function.py

from logic import process_data

def lambda_handler(event, context):

return process_data(event)環境変数の活用

- ポイント: 環境ごとに異なる設定値(データベースの接続先、S3バケット名など)は、環境変数で管理します。

- メリット:

- コードの変更なしで環境設定を切り替え可能。

- セキュリティを向上(AWS Secrets ManagerやSSM Parameter Storeとも連携可能)。

例:

import os

def lambda_handler(event, context):

bucket_name = os.environ("S3_BUCKET_NAME")

print(f"Using bucket: {bucket_name}")デコレータを使った共通処理の抽象化

- ポイント: ロギングやエラーハンドリング、トレースの追加処理をデコレータで実装。

- メリット:

- 冗長なコードを削減。

- 複数の関数に一貫した共通処理を適用可能。

例:

from functools import wraps

def log_execution(func):

@wraps(func)

def wrapper(event, context):

print("Event received:", event)

try:

return func(event, context)

except Exception as e:

print("Error:", e)

raise

return wrapper

@log_execution

def lambda_handler(event, context):

return {"message": "Hello, world!"}イベント駆動型の処理パターン

- ポイント: イベントタイプごとに処理を分岐させる。

- メリット:

- 多種多様なイベントに対応可能。

- スケーラブルなコード設計。

例:

def handle_s3_event(event):

print("Handling S3 event")

# S3特有の処理

def handle_sns_event(event):

print("Handling SNS event")

# SNS特有の処理

def lambda_handler(event, context):

event_source = event.get("source")

if event_source == "aws.s3":

handle_s3_event(event)

elif event_source == "aws.sns":

handle_sns_event(event)

else:

raise ValueError(f"Unknown event source: {event_source}")グローバルスコープを使った初期化の最適化

- ポイント: 初期化コストの高い処理(データベース接続、外部クライアントなど)はグローバルスコープで一度だけ実行。

- メリット:

- 初期化のオーバーヘッドを削減。

- ウォームスタート時の効率化。

例:

import boto3

# グローバルスコープ

s3_client = boto3.client("s3")

def lambda_handler(event, context):

s3 = get_s3_client()

print(s3.list_buckets())ファイル構成によるモジュール化

- ポイント: 大きなプロジェクトではディレクトリ構成を工夫し、ロジック、ユーティリティ、テストを分離。

- メリット:

- メンテナンス性が向上。

- 複数人開発に対応しやすい。

例:

project/

├── lambda_function.py # ハンドラー

├── logic/

│ ├── __init__.py

│ ├── business_logic.py

├── utils/

│ ├── __init__.py

│ ├── helpers.py

└── tests/

├── test_lambda.pyエラーハンドリングの徹底

- ポイント: 例外が起きても適切に処理し、再試行や通知を行う仕組みを実装。

- メリット:

- ロバスト性向上。

- デバッグが容易。

例:

import logging

import traceback

logger = logging.getLogger()

logger.setLevel(logging.INFO)

def lambda_handler(event, context):

try:

# メインロジック

result = {"message": "Success"}

return { "statusCode": 200, "body": result }

except Exception as e:

logger.error("Error occurred: %s", e)

logger.error(traceback.format_exc())

return {

"statusCode": 200,

"body": {"error": "Internal server error", "message": str(e)}

}これらの設計パターンを組み合わせることで、AWS LambdaをPythonで効率的に実装できます。

ぜひ、参考にしてみてください。

実用的なユースケース実装

AWS Lambdaの実践的な活用例として、運用コストの最適化に直結する2つのユースケースを紹介します。

実装例を通じて、実務での効果的な活用方法を学びましょう。

CloudWatchログのバックアップ

CloudWatchログを定期的にS3にバックアップすることで、長期保存のコストを削減できます。

import boto3

from datetime import datetime, timedelta

from typing import Dict, Any, List

import logging

import traceback

import os

logger = logging.getLogger()

logger.setLevel(logging.INFO)

class CloudWatchLogsBackup:

def __init__(self):

self.logs_client = boto3.client('logs')

self.s3_client = boto3.client('s3')

def get_log_groups(self) -> List[str]:

"""バックアップ対象のロググループを取得(ページネーション対応)"""

log_groups = []

paginator = self.logs_client.get_paginator('describe_log_groups')

for page in paginator.paginate():

log_groups.extend([group['logGroupName'] for group in page['logGroups']])

return log_groups

def export_logs(self, log_group: str, bucket: str) -> None:

"""ログをS3にエクスポート"""

now = datetime.now()

yesterday = now - timedelta(days=1)

task_name = f"export-{log_group.replace('/', '-')}-{yesterday.strftime('%Y-%m-%d')}"

try:

# エクスポートタスクを作成

response = self.logs_client.create_export_task(

logGroupName=log_group,

fromTime=int(yesterday.timestamp() * 1000),

to=int(now.timestamp() * 1000),

destination=bucket,

destinationPrefix=f"logs/{log_group}",

taskName=task_name

)

logger.info({

'message': 'Export task created',

'task_id': response['taskId'],

'log_group': log_group

})

except Exception as e:

logger.error({

'message': 'Export failed',

'log_group': log_group,

'error': str(e),

'trace': traceback.format_exc()

})

def lambda_handler(event: Dict[str, Any], context: Any) -> Dict[str, Any]:

backup = CloudWatchLogsBackup()

bucket_name = os.environ("S3_BUCKET_NAME")

for log_group in backup.get_log_groups():

try:

backup.export_logs(log_group, bucket_name)

except: Exception as e:

logger.error({

'message': 'Failed to export logs for log group',

'log_group': log_group,

'error': str(e),

'trace': traceback.format_exc()

})

return {'status': 'success'}

非アクティブリソースの停止

未使用のEC2インスタンスを自動で停止することで、不要なコストを削減できます。

import boto3

import logging

from typing import Dict, Any, List

from datetime import datetime, timedelta

import os

# ロガーの初期化

logger = logging.getLogger()

logger.setLevel(logging.INFO)

# boto3クライアントのグローバル初期化

ec2_client = boto3.client('ec2')

cloudwatch = boto3.client('cloudwatch')

class ResourceOptimizer:

def __init__(self):

self.ec2_client = ec2_client

self.cloudwatch = cloudwatch

self.cpu_threshold = float(os.getenv('CPU_THRESHOLD', 10.0))

def get_inactive_instances(self) -> List[str]:

"""CPU使用率が閾値未満のインスタンスを特定"""

now = datetime.utcnow()

inactive_instances = []

paginator = self.ec2_client.get_paginator('describe_instances')

for page in paginator.paginate(

Filters=[{'Name': 'instance-state-name', 'Values': ['running']}]

):

for reservation in page['Reservations']:

for instance in reservation['Instances']:

try:

# CloudWatchメトリクスの取得

response = self.cloudwatch.get_metric_statistics(

Namespace='AWS/EC2',

MetricName='CPUUtilization',

Dimensions=[{'Name': 'InstanceId', 'Value': instance['InstanceId']}],

StartTime=now - timedelta(hours=1),

EndTime=now,

Period=300,

Statistics=['Average']

)

if response['Datapoints']:

avg_cpu = sum(d['Average'] for d in response['Datapoints']) / len(response['Datapoints'])

if avg_cpu < self.cpu_threshold:

logger.info(f"Instance {instance['InstanceId']} is inactive (CPU: {avg_cpu}%)")

inactive_instances.append(instance['InstanceId'])

except Exception as e:

logger.error(f"Error retrieving metrics for {instance['InstanceId']}: {e}")

return inactive_instances

def stop_instances(self, instance_ids: List[str]) -> None:

"""インスタンスを停止"""

if instance_ids:

try:

self.ec2_client.stop_instances(InstanceIds=instance_ids)

logger.info(f"Stopped instances: {instance_ids}")

except Exception as e:

logger.error(f"Error stopping instances {instance_ids}: {e}")

def lambda_handler(event: Dict[str, Any], context: Any) -> Dict[str, Any]:

logger.info("Lambda function started")

optimizer = ResourceOptimizer()

# 非アクティブなインスタンスを特定

inactive_instances = optimizer.get_inactive_instances()

# インスタンスを停止

optimizer.stop_instances(inactive_instances)

return {

'status': 'success',

'stopped_instances': inactive_instances

}

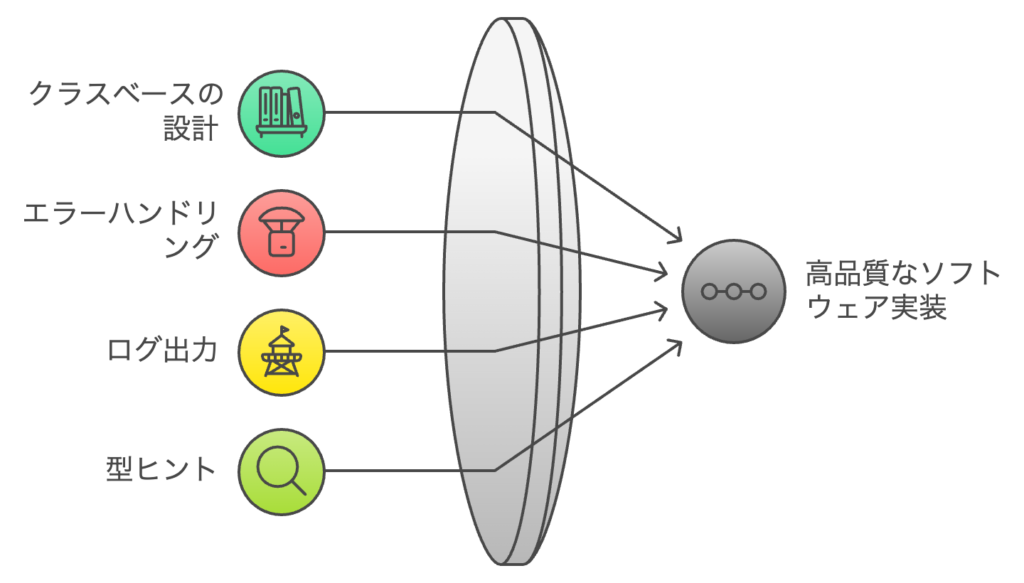

これらの実装例は、以下のような特徴があります。

- クラスベースの設計で保守性が高い

- エラーハンドリングが適切に実装されている

- ログ出力で運用監視が容易

- 型ヒントでコードの安全性が向上

実務では、これらの基本実装をベースに、より細かな要件に応じてカスタマイズすることになります。

パフォーマンス最適化

AWS Lambdaの実行パフォーマンスを最適化することで、コストの削減と応答時間の改善が実現できます。

ここでは、実務で効果的な2つの最適化アプローチを解説します。

ウォームスタート時の効率化

Lambda関数のウォームスタートを考慮に入れて、実装することで、実行時間とコストを効率化することができます。

以下は、その一例になります。

# グローバルスコープでの初期化

import boto3

import json

from typing import Dict, Any

# 共通のクライアントを初期化

s3_client = boto3.client('s3')

dynamodb = boto3.resource('dynamodb')

table = dynamodb.Table('my-table')

# 設定値の読み込み

CONFIG = {

'batch_size': 100,

'timeout': 30

}

def lambda_handler(event: Dict[str, Any], context: Any) -> Dict[str, Any]:

# 初期化済みのクライアントを使用

response = table.get_item(

Key={'id': event['id']}

)

return responseメモリ使用量の最適化

メモリ使用量を最適化することで、コストの削減と処理の安定性が向上します。

from typing import Generator, Dict, Any

import csv

import os

from tempfile import NamedTemporaryFile

def transform_item(item: Dict[str, Any]) -> Dict[str, Any]:

"""データ変換処理(例)"""

return {"id": item["id"], "value": item["value"] * 2}

def process_large_data(items: Generator[Dict[str, Any], None, None]) -> Generator[Dict[str, Any], None, None]:

"""ジェネレータを使用した大量データ処理"""

for item in items:

yield transform_item(item)

def export_to_csv(data: list) -> str:

try:

with NamedTemporaryFile(mode='w+', delete=False) as temp_file:

fieldnames = data[0].keys() if data else []

writer = csv.DictWriter(temp_file, fieldnames=fieldnames)

writer.writeheader()

for item in process_large_data(data):

writer.writerow(item)

return temp_file.name

except Exception as e:

print(f"Error exporting to CSV: {e}")

return ""

finally:

if temp_file.name:

try:

os.unlink(temp_file.name)

except OSError as e:

print(f"Error deleting temp file {temp_file.name}: {e}")

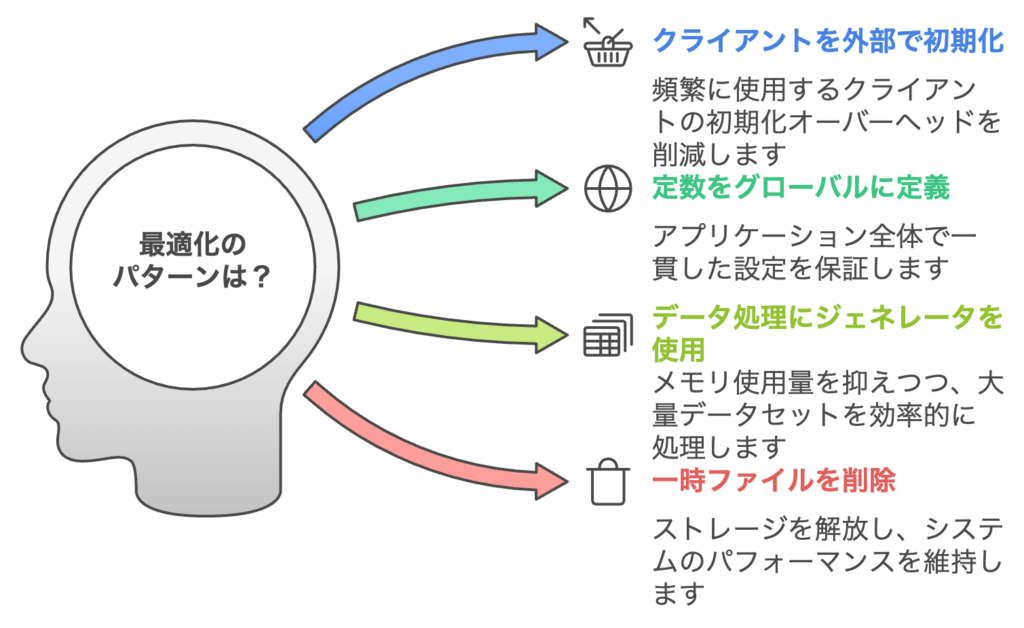

これらの最適化手法のポイントは以下の通りです。

- 頻繁に使用するクライアントは関数外で初期化

- 設定値は定数としてグローバルに定義

- 大量データ処理にはジェネレータを活用

- 一時ファイルは適切なタイミングで削除

実装時は、処理の内容に応じて適切な最適化手法を選択することが重要です。

運用管理のベストプラクティス

Lambda関数の安定運用には、適切な監視と運用体制の構築が不可欠です。

ここでは、実務で効果的な運用管理の手法を解説します。

ログ設計

効率的なトラブルシューティングのために、構造化ログを実装します。

import logging

import json

from typing import Any, Dict

from datetime import datetime

logger = logging.getLogger()

logger.setLevel(logging.INFO)

def structured_log(

message: str,

log_level: str = "INFO",

**kwargs: Any

) -> None:

"""構造化ログを出力"""

log_data = {

"timestamp": datetime.now().isoformat(),

"level": log_level,

"message": message,

**kwargs

}

logger.info(json.dumps(log_data))

def lambda_handler(event: Dict[str, Any], context: Any) -> Dict[str, Any]:

start_time = datetime.now()

try:

# 処理開始のログ

structured_log(

"Processing started",

request_id=context.aws_request_id,

event_type=event.get('type')

)

# 処理実行

result = process_data(event)

# 実行時間の計算

execution_time_ = (datetime.now() - start_time).total_seconds()

# 正常終了のログ

structured_log(

"Processing completed",

execution_time=execution_time,

result_count=len(result)

)

return {"statusCode": 200, "body": result}

except Exception as e:

# エラーログ

structured_log(

"Error occurred",

log_level="ERROR",

error_type=type(e).__name__,

error_message=str(e)

)

raiseモニタリング設定

CloudWatch Alarmsを使用して、異常を早期検知します。

以下は、アラームの作成例です。

import boto3

from typing import Dict, Any

def setup_monitoring(function_name: str) -> None:

"""モニタリングアラームを設定"""

cloudwatch = boto3.client('cloudwatch')

# エラー率のアラーム

cloudwatch.put_metric_alarm(

AlarmName=f"{function_name}-error-rate",

MetricName="Errors",

Namespace="AWS/Lambda",

Dimensions=[{

'Name': 'FunctionName',

'Value': function_name

}],

Period=300, # 5分間

EvaluationPeriods=2,

Threshold=1.0,

ComparisonOperator='GreaterThanThreshold',

Statistic='Sum',

ActionsEnabled=True,

AlarmActions=['SNSトピックのARN']

)運用管理のポイントは以下の通りです。

- ログは必ず構造化して出力

- 重要なメトリクスはアラーム設定

これらの施策により、安定した運用と早期の問題検知が可能になります。

次のステップ

AWS LambdaとPythonの基本的な実装パターンを理解したら、より高度な活用方法にチャレンジしましょう。

より高度な実装パターン

AWS Step Functionsとの連携により、複雑なワークフローを実現できます。

例えば、以下のようなユースケースが考えられます。

- 大規模データの非同期処理

- 複数サービスの連携処理

- エラーリトライのハンドリング

パフォーマンスチューニング

より高度なパフォーマンス最適化に取り組むことで、運用コストを削減できます。

主なアプローチとして:

- 並列処理の実装

- キャッシュ戦略の採用

- データベースクエリの最適化

マイクロサービスアーキテクチャでの活用

Lambdaを活用したマイクロサービスの構築により、柔軟なシステム設計が可能です。

検討すべきポイントとして:

- APIインターフェースの設計

- サービス間通信の実装

- 認証・認可の統合

これらの応用的なトピックは、以下の学習リソースで深めることができます。

- AWS公式ドキュメント

- AWSのハンズオンラボ

- コミュニティのベストプラクティス

キャリアの次のステップとして、AWS認定試験へのチャレンジもおすすめです。

コメント